近日,人工智能領(lǐng)域頂級會議AAAI公布了2025年的論文錄用結(jié)果,深圳北理莫斯科大學(xué)粵港澳情感智能與普適計算聯(lián)合實驗室?guī)熒陡宓牧恼马樌脒x,文章涉及到情感計算、自動駕駛、自然語言處理等多個研究領(lǐng)域。

?AAAI為國際人工智能協(xié)會(Association for the Advancement of Artificial Intelligence)?,每年舉辦的AAAI年會是人工智能領(lǐng)域的頂級會議,是中國計算機(jī)學(xué)會CCF推薦的A類國際學(xué)術(shù)會議。本次會議共有12,957篇投稿,接收率僅為 23.4%。會議將于2025年2月25日-3月4日在美國賓夕法尼亞州費城召開。

入選論文介紹

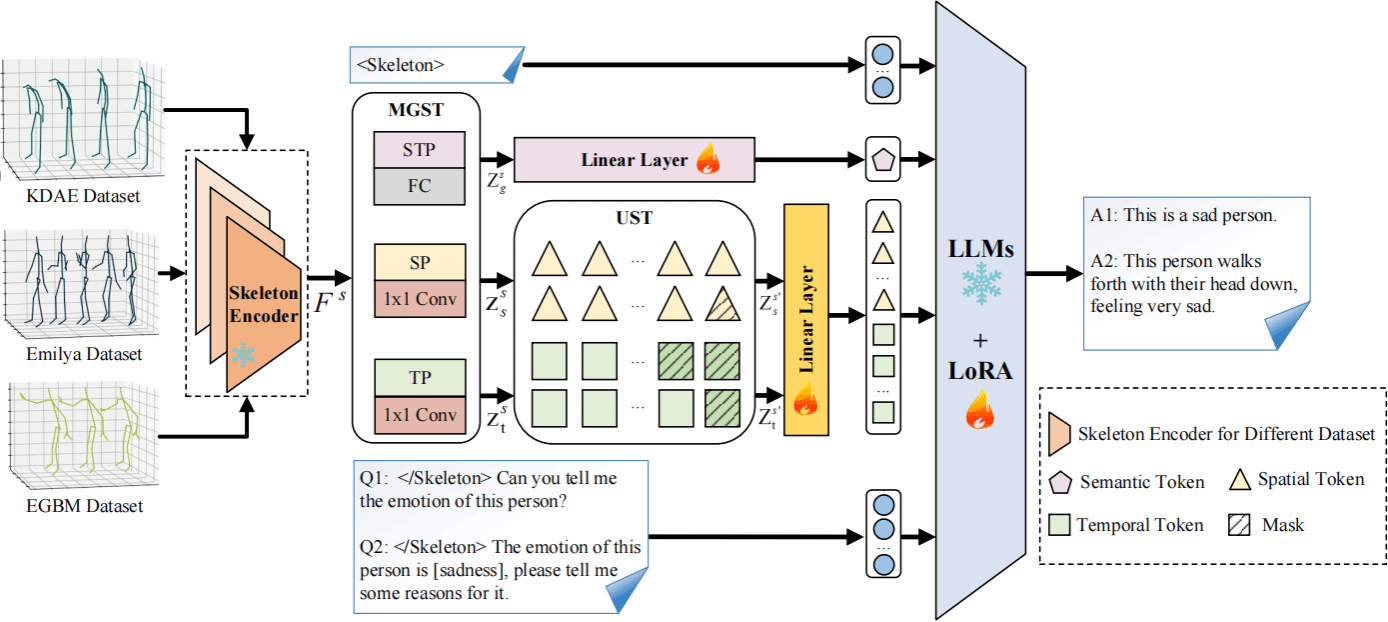

1. 論文題目:Understanding Emotional Body Expressions via Large Language Models

摘要:

基于肢體動作的情感識別在人機(jī)交互中至關(guān)重要。然而,現(xiàn)有方法主要聚焦于情感分類,不能進(jìn)一步提供文本解釋來驗證其分類的合理性。本文提出了一個由大語言模型驅(qū)動的情緒-動作解釋器(EAI-LLM),它不僅可以識別情緒,還可以針對輸入的3D骨架序列來生成相應(yīng)的文本解釋。具體而言,研究將骨架序列視為一種特殊的語言,提出一種多粒度骨架序列標(biāo)記器。該標(biāo)記器可以將來自異構(gòu)數(shù)據(jù)集的骨架序列統(tǒng)一提取時空標(biāo)記和語義標(biāo)記,利用LLMs廣泛的背景知識和語言處理能力來解決異構(gòu)數(shù)據(jù)集聯(lián)合訓(xùn)練的挑戰(zhàn),從而顯著提高識別精度,并生成細(xì)粒度的情感描述。實驗結(jié)果表明,在LLMs背景知識的支持下,EAI-LLM模型可以在有限標(biāo)記的骨架序列上進(jìn)行微調(diào),生成詳細(xì)的情緒描述,且識別精度與現(xiàn)有方法相當(dāng)甚至更佳。

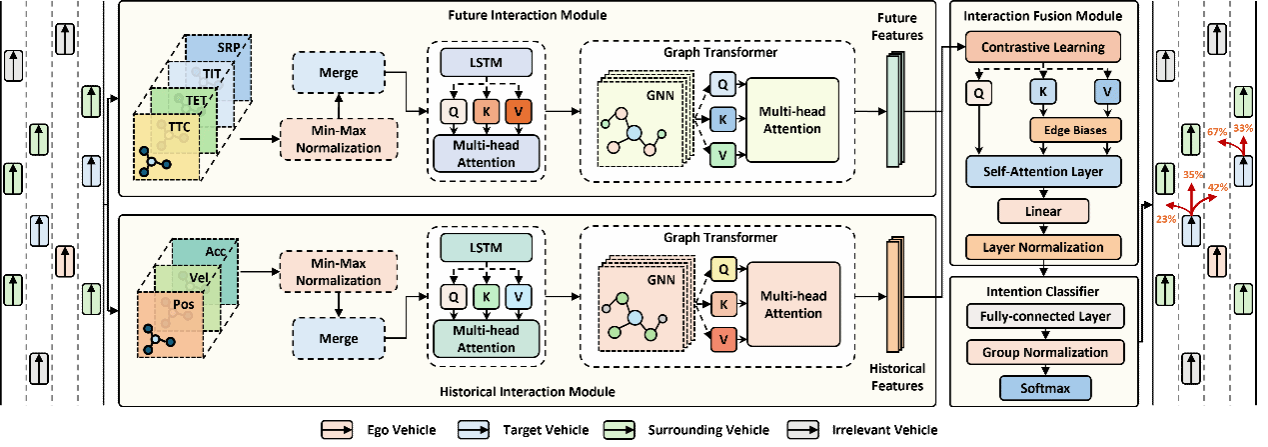

2. 論文題目:Dual-View Interaction-Aware Lane Change Prediction for Autonomous Driving

摘要:

隨著人工智能技術(shù)的不斷發(fā)展,我們正邁向自動駕駛車輛廣泛部署的關(guān)鍵時刻。然而,由此帶來的混合自主交通環(huán)境為自動駕駛車輛帶來了嚴(yán)峻挑戰(zhàn),尤其是對周圍有人駕駛車輛變道意圖的準(zhǔn)確預(yù)測,這對于保障自動駕駛車輛的安全至關(guān)重要。現(xiàn)有的變道預(yù)測模型主要集中于捕捉單輛車輛運動動態(tài)的時間變化,但忽視了車輛間的交互關(guān)系,這在復(fù)雜的變道場景中限制了其預(yù)測能力,導(dǎo)致性能不理想。此外,目前的交互感知方法無法對車輛之間的未來交互進(jìn)行建模,容易產(chǎn)生不合理的預(yù)測結(jié)果,可能引發(fā)車輛碰撞。針對上述問題,本研究提出將感知安全的概念融入未來交互建模,并設(shè)計了一種雙視角交互感知變道預(yù)測模型。在兩個真實數(shù)據(jù)集上的評估結(jié)果表明,該模型在分類能力上相比表現(xiàn)最優(yōu)的基線模型平均提升了11.7%-12.4%,在預(yù)測能力上提升了75.6%-95.7%。通過消融研究和對未來交互建模的分析,證明了我們模型在從駕駛安全視角解釋變道場景方面的優(yōu)勢,并實現(xiàn)了社會化感知的變道預(yù)測。

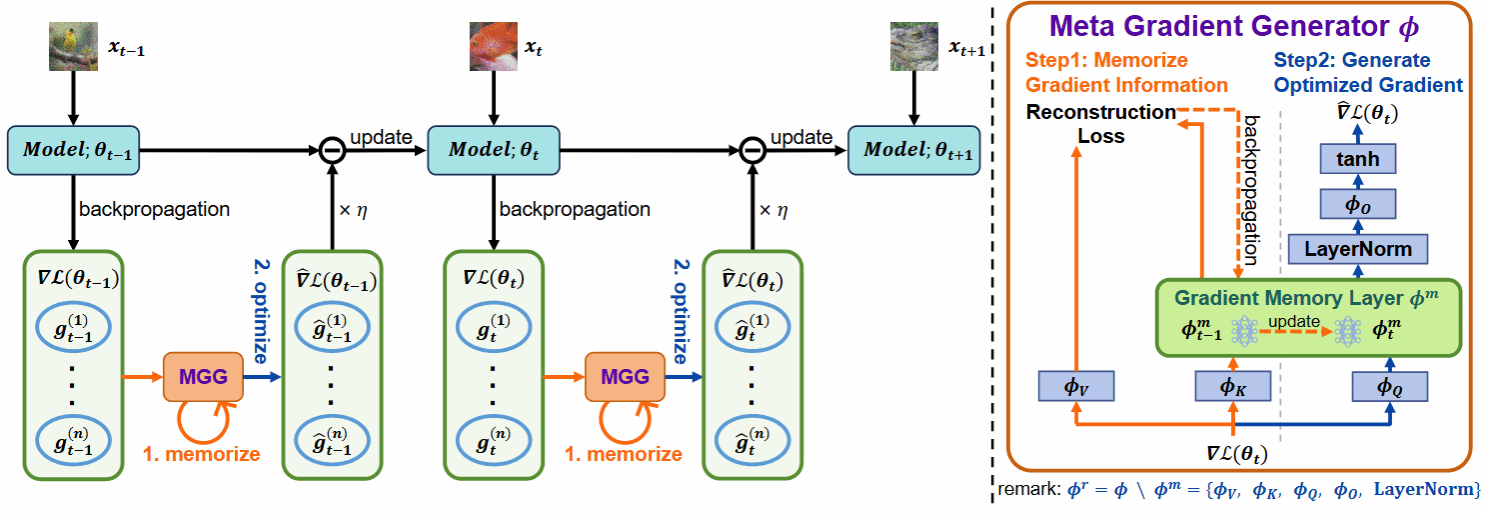

3. 論文題目:Learning to Generate Gradients for Test-Time Adaptation

摘要:

測試時自適應(yīng)(TTA)旨在使用未標(biāo)記的測試數(shù)據(jù)在線微調(diào)已訓(xùn)練好的模型,以適應(yīng)新環(huán)境或分布外的數(shù)據(jù),在實際場景中表現(xiàn)出廣泛的應(yīng)用潛力。然而,在這個優(yōu)化過程中,像熵最小化這樣的無監(jiān)督學(xué)習(xí)目標(biāo)經(jīng)常會遇到嘈雜的學(xué)習(xí)信號。這些信號產(chǎn)生不可靠的梯度,阻礙了模型快速收斂到最優(yōu)解的能力,并在優(yōu)化過程中引入了顯著的不穩(wěn)定性。本研究試圖從優(yōu)化器設(shè)計的角度解決這些問題。與之前使用 SGD 等手動設(shè)計的優(yōu)化器的TTA方法不同,我們采用一種學(xué)習(xí)優(yōu)化的方法來自動學(xué)習(xí)一個稱為元梯度生成器(MGG)的優(yōu)化器。具體來說,研究的目標(biāo)是讓MGG在在線優(yōu)化過程中有效利用歷史梯度信息來優(yōu)化當(dāng)前模型。為此,在MGG中,我們設(shè)計了一個輕量級且高效的序列建模層——梯度記憶層。它利用自監(jiān)督重構(gòu)損失將歷史梯度信息壓縮為網(wǎng)絡(luò)參數(shù),從而在長期適應(yīng)過程中實現(xiàn)更好的記憶能力。只需要少量未標(biāo)記的樣本來預(yù)訓(xùn)練MGG,就可以部署訓(xùn)練后的MGG來處理未見過的樣本。ImageNet-C/R/Sketch/A上的實驗結(jié)果表明,這一研究的方法以更少的更新次數(shù)、更少的數(shù)據(jù)和更短的自適應(yīng)時間超越了當(dāng)前最先進(jìn)的方法。與之前的SOTA方法SAR相比,本文的研究在ImageNet-C上實現(xiàn)了7.4%的準(zhǔn)確率和4.2倍的適應(yīng)速度提升。

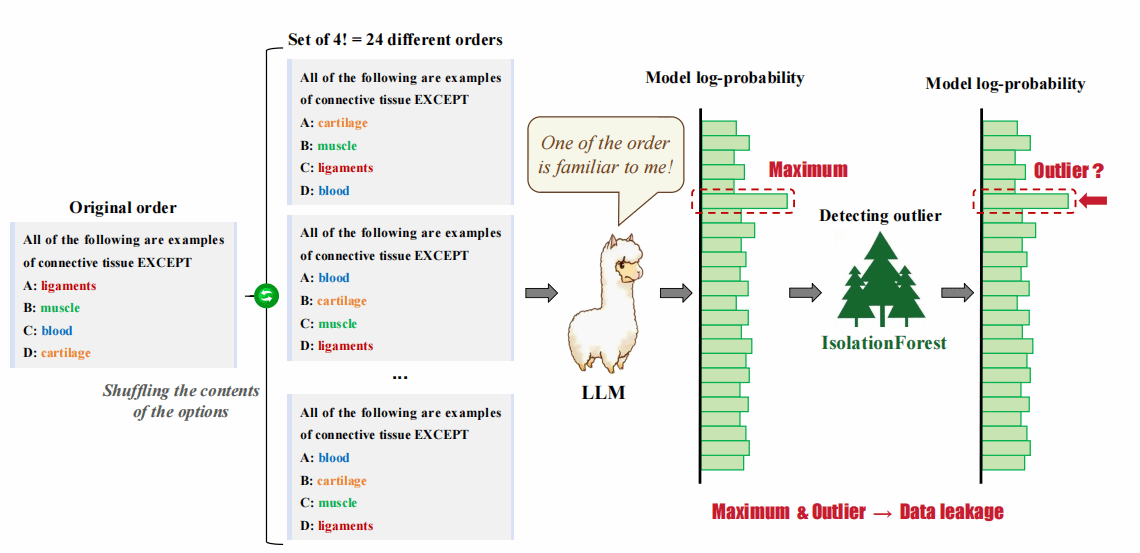

4. Training on the Benchmark Is Not All You Need

摘要:

大規(guī)模語言模型(LLMs)的成功在很大程度上依賴于在預(yù)訓(xùn)練階段學(xué)習(xí)到的大量預(yù)訓(xùn)練數(shù)據(jù)。預(yù)訓(xùn)練過程及其數(shù)據(jù)的不透明性導(dǎo)致許多基準(zhǔn)測試的結(jié)果變得不可靠。如果任何模型已經(jīng)在基準(zhǔn)測試集上進(jìn)行了訓(xùn)練,這可能會嚴(yán)重阻礙該領(lǐng)域的健康發(fā)展。為了自動化和高效地測試大規(guī)模語言模型的能力,許多主流基準(zhǔn)測試采用了多項選擇題的格式。由于多項選擇題選項內(nèi)容的交換不影響問題本身的含義,該研究提出了一種基于這一特性的簡單有效的數(shù)據(jù)泄露檢測方法。具體來說,研究通過打亂數(shù)據(jù)中選項的內(nèi)容來生成相應(yīng)的衍生數(shù)據(jù)集,然后基于模型在這些衍生數(shù)據(jù)集上的對數(shù)概率分布檢測數(shù)據(jù)泄露。如果在對數(shù)概率的集合中存在最大值或異常值,便表示數(shù)據(jù)發(fā)生了泄露。該論文研究的方法能夠在黑盒條件下工作,無需訪問模型的訓(xùn)練數(shù)據(jù)或權(quán)重,有效識別模型預(yù)訓(xùn)練數(shù)據(jù)中來自基準(zhǔn)測試集的數(shù)據(jù)泄露,包括正常情況以及選項可能被有意或無意地打亂的復(fù)雜情況。通過基于兩種大規(guī)模語言模型和基準(zhǔn)設(shè)計的實驗,該研究展示了該方法的有效性。此外,研究還評估了31個主流開源大規(guī)模語言模型在四個基準(zhǔn)數(shù)據(jù)集上的數(shù)據(jù)泄露程度,并對每個基準(zhǔn)數(shù)據(jù)集中的泄露模型進(jìn)行了排名,發(fā)現(xiàn)Qwen家族的大規(guī)模語言模型泄露程度最高。

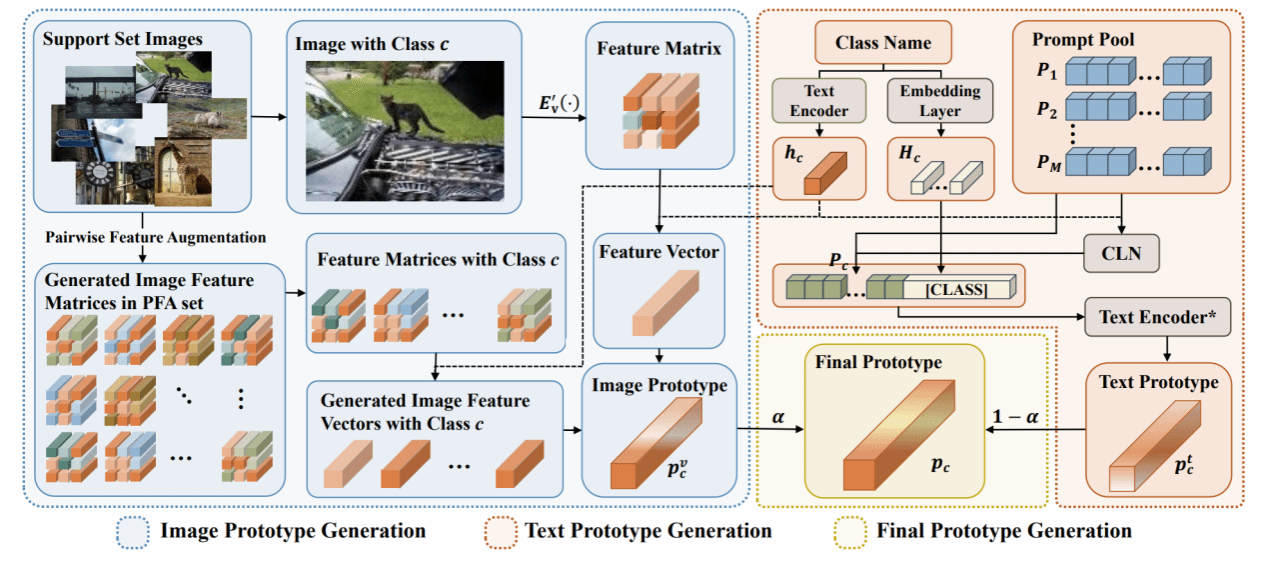

5. 論文題目:Multi-Label Few-Shot Image Classification via Pairwise Feature Augmentation and Flexible Prompt Learning

摘要:

由于注釋數(shù)據(jù)有限和類別特異性難以捉摸,多標(biāo)簽少樣本圖像分類是一項至關(guān)重要且極具挑戰(zhàn)性的任務(wù)。然而,對這一課題的研究仍處于初級階段,可用的方法很少。現(xiàn)有的方法要么利用數(shù)據(jù)增強(qiáng)來緩解數(shù)據(jù)稀缺的問題,要么利用標(biāo)簽特征作為輔助知識來消除不相關(guān)類別帶來的負(fù)面影響,但它們忽視了利用圖像區(qū)域特征進(jìn)行數(shù)據(jù)增強(qiáng),也忽略了學(xué)習(xí)適當(dāng)?shù)奈谋咎卣鱽砀玫仄ヅ涮囟悇e的圖像特征。此外,這些方法只關(guān)注了一個方面,沒有同時有效地解決上述兩個問題。本文介紹了一種新穎的基于原型的多標(biāo)簽少樣本圖像學(xué)習(xí)框架,它將成對特征增強(qiáng)和靈活的提示學(xué)習(xí)結(jié)合在一起。具體來說,通過成對特征增強(qiáng),利用支持集中圖像的區(qū)域特征來生成更多圖像特征并構(gòu)建圖像原型,從而緩解了數(shù)據(jù)稀缺的問題。通過靈活的提示學(xué)習(xí),自適應(yīng)地獲取特定類別的提示,構(gòu)建與特定類別圖像特征高度匹配的文本原型,從而減輕無關(guān)類別的影響。最后,通過自適應(yīng)可學(xué)習(xí)參數(shù),將圖像原型和文本原型合并,得到最終原型,從而為多標(biāo)簽少樣本圖像分類提供更強(qiáng)大的分類器。廣泛的實驗結(jié)果表明,這一研究提出的方法可以將基準(zhǔn)性能推向更高水平。

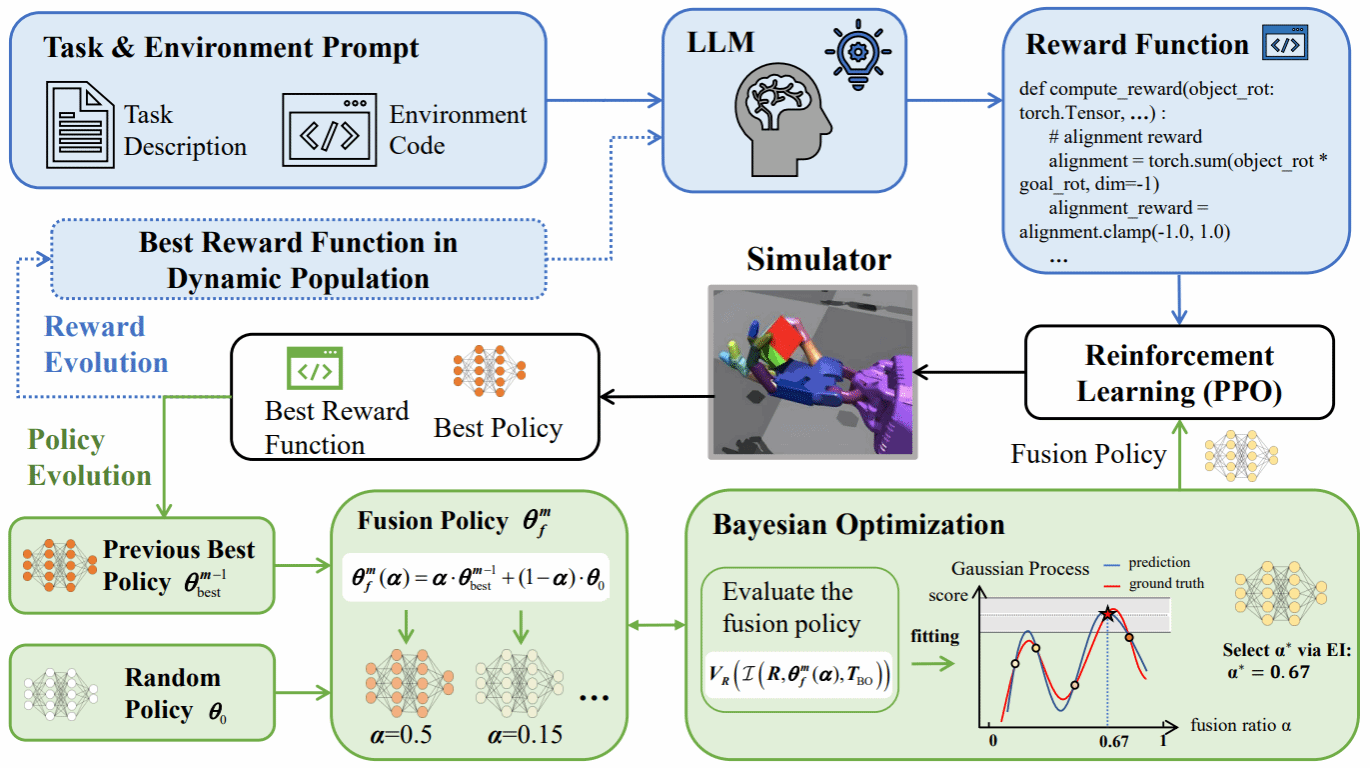

6. 論文題目:Efficient Language-instructed Skill Acquisition via Reward-Policy Co-Evolution

摘要:

在機(jī)器人自主學(xué)習(xí)領(lǐng)域,高效地通過語言指令獲取技能對于減少人工指導(dǎo)至關(guān)重要。盡管強(qiáng)化學(xué)習(xí)方法在很大程度上減輕了人工干預(yù),但設(shè)計真實世界任務(wù)的獎勵函數(shù),尤其是高維機(jī)器人控制任務(wù)的獎勵函數(shù),仍然面臨巨大挑戰(zhàn)。最近,隨著大型語言模型(LLMs)的進(jìn)步,自動設(shè)計獎勵函數(shù)變得可行。然而,現(xiàn)有方法在評估獎勵函數(shù)時,往往需要從頭開始重新訓(xùn)練策略,這對獎勵函數(shù)提出了過高的要求,期望其在策略改進(jìn)的每個階段——從初始階段到收斂階段——都能有效。為了解決這一問題,本文提出了一種新穎的獎勵-策略共同演化框架(ROSKA),該框架允許獎勵函數(shù)和學(xué)習(xí)策略相互促進(jìn)、共同演化,從而在每個階段逐步實現(xiàn)即時改進(jìn),最終高效地獲取機(jī)器人技能。具體而言,獎勵演化過程通過將機(jī)器人之前最優(yōu)的獎勵函數(shù)、任務(wù)描述和環(huán)境信息轉(zhuǎn)化為文本輸入,查詢LLMs生成多個獎勵函數(shù)候選,并確保每輪演化都能帶來持續(xù)改進(jìn)。在策略演化方面,本研究的方法通過混合歷史最優(yōu)策略和隨機(jī)策略來生成新的策略種群。結(jié)合改進(jìn)的貝葉斯優(yōu)化算法,本研究的方法能夠高效且穩(wěn)健地識別最具潛力的獎勵-策略組合,進(jìn)而進(jìn)入下一輪的共同演化。實驗結(jié)果表明,這一研究的方法能夠在使用更少的訓(xùn)練樣本情況下在多種高維機(jī)器人技能學(xué)習(xí)任務(wù)中實現(xiàn)了平均95.3%的歸一化性能提升,突出了其在提高機(jī)器人在復(fù)雜環(huán)境中的適應(yīng)性和精確性方面的有效性。通過與稀疏獎勵方法、人工設(shè)計獎勵方法以及傳統(tǒng)LLM設(shè)計獎勵函數(shù)方法的比較,ROSKA在所有任務(wù)中均展現(xiàn)出卓越的性能,特別是在ShadowHand和FrankaCabinet任務(wù)中,分別實現(xiàn)了相對于人工設(shè)計獎勵的4倍和8倍性能提升。這些結(jié)果不僅證明了ROSKA在機(jī)器人自主學(xué)習(xí)領(lǐng)域的巨大潛力,也展示了其在實際應(yīng)用中的廣泛適用性。